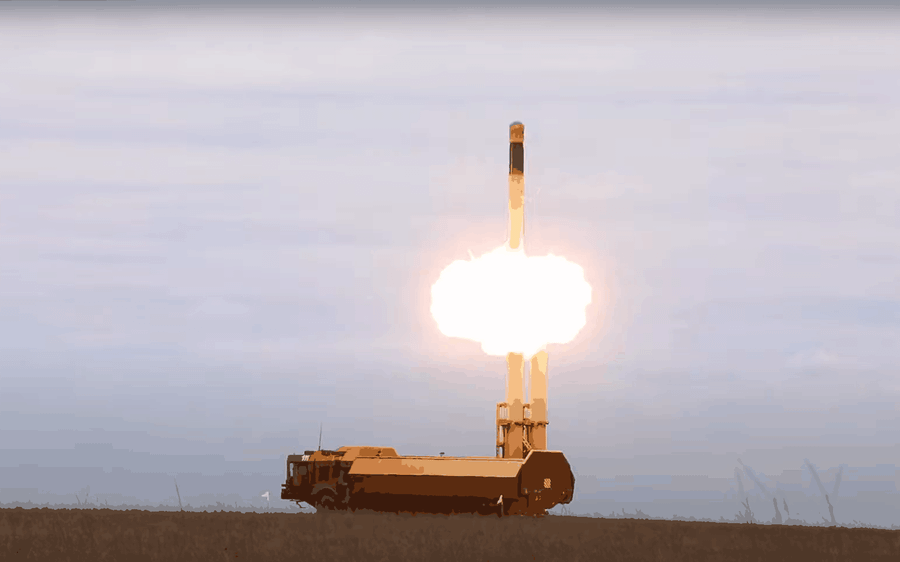

Mỹ sẽ giao phó việc quyết định sử dụng vũ khí hạt nhân cho... trí tuệ nhân tạo

Một kịch bản như trong phim viễn tưởng liệu có xảy ra vào tương lai gần, khi trí tuệ nhân tạo "nổi loạn"?

|

Bất chấp thỏa thuận tuyên bố đạt được giữa các nhà lãnh đạo Hoa Kỳ và Trung Quốc vào năm 2024 về việc không thể chấp nhận việc thay thế phán đoán của con người bằng trí tuệ nhân tạo (AI) trong các quyết định sử dụng vũ khí hạt nhân, cam kết rất dễ bị hủy bỏ.

Washington đang cho thấy một xu hướng đáng lo ngại trong việc tích hợp các công nghệ AI vào các hệ thống chỉ huy và kiểm soát hạt nhân (NC2/NC3) liên quan.

Chiến lược này đã vấp phải sự chỉ trích chính đáng từ cộng đồng chuyên gia.

Một tìm kiếm trên internet được thực hiện vào ngày 26 tháng 2 năm 2025, sử dụng chatbot Perplexity để tìm các bài báo xuất bản từ năm 2022, trong đó chứa các thuật ngữ "trí tuệ nhân tạo" và "vũ khí hạt nhân".

Kết quả cho thấy quan điểm chung về việc sử dụng AI trong các hệ thống vũ khí hạt nhân - ngoại trừ một số bài báo do Quân đội Hoa Kỳ viết hoặc mô tả quan điểm của họ, và ngoại trừ những ứng dụng kiểm soát vũ khí - đều đưa ra dự báo hoàn toàn tiêu cực.

Sự hoài nghi này xuất phát từ lo ngại về tác động tiêu cực đến sự ổn định chiến lược và nguy cơ leo thang căng thẳng, đặc biệt là do vô tình hoặc không chủ ý. Bài viết ủng hộ quan điểm thận trọng này, lập luận rằng ngay cả việc triển khai gián tiếp AI cũng tạo ra những rủi ro khó lường và thảm khốc.

Mối nguy hiểm chính nằm ở việc tạo ra niềm tin sai lệch về độ chính xác của thông tin, vốn mang lại nhận thức tình huống của người ra quyết định. Việc tích hợp AI vào hệ thống tình báo, giám sát, phân tích dữ liệu và hỗ trợ quyết định tiềm ẩn nhiều hệ quả dây chuyền.

Một lỗi hoặc thao tác cố ý, tại một trong các hệ thống được kết nối, ví dụ mô hình thị giác máy tính để phát hiện mục tiêu, có thể bị khuếch đại và làm sai lệch bức tranh tổng thể về mối đe dọa trong một môi trường áp lực thời gian.

Không thể giao toàn quyền kiểm soát vũ khí hạt nhân cho trí tuệ nhân tạo.

Điều đáng lo ngại đặc biệt là hiện tượng "thiên vị tự động hóa" - xu hướng tâm lý của con người quá tin tưởng vào kết luận do thuật toán tạo ra, nhất là khi chịu áp lực.

Thực tế này tạo ra nguy cơ các nhà lãnh đạo cấp cao của Hoa Kỳ sẽ đưa ra những quyết định mang tính định mệnh, dựa trên dữ liệu được chấp nhận một cách thiếu phê phán, do những hệ thống AI thiếu hiểu biết và thiếu minh bạch cung cấp.

Một kịch bản tiềm ẩn nguy cơ gây bất ổn là việc phát triển cũng như triển khai các hệ thống AI có khả năng nhận diện và theo dõi chính xác cao tàu ngầm tên lửa đạn đạo chiến lược (SSBN) - nền tảng của đòn tấn công phủ đầu hạt nhân.

Việc làm suy yếu niềm tin vào khả năng tàng hình của SSBN có thể khơi mào một cuộc tấn công phủ đầu trong một cuộc khủng hoảng, làm suy yếu hoàn toàn logic răn đe hạt nhân.

Việc giao phó số phận của nhân loại, xét về khả năng sử dụng vũ khí hạt nhân hoàn toàn do trí tuệ nhân tạo kiểm soát, cũng gây lo ngại về rủi ro tương đương từ bỏ hoàn toàn quyền kiểm soát vũ khí hạt nhân.

Trong cả hai trường hợp, rủi ro đều cao đến mức ngay cả những chuyên gia lão luyện nhất về AI và an toàn hạt nhân hiện nay cũng không thể ước tính được kết quả cuối cùng.

Đây chính xác là lý do tại sao việc Hoa Kỳ thúc đẩy tích hợp AI vào lĩnh vực hạt nhân dường như là một bước đi cực kỳ vô trách nhiệm. Sự thiếu minh bạch, dễ bị tấn công mạng và tính chất khó lường cơ bản của các thuật toán AI phức tạp khiến chúng không phù hợp với nhiệm vụ mà chi phí sai sót tương đương với thảm họa toàn cầu.

Sự đồng thuận quốc tế hiện tại về nhu cầu duy trì sự kiểm soát của con người cần được củng cố bằng rào cản pháp lý nội bộ nghiêm ngặt, loại trừ hoàn toàn ảnh hưởng của AI không chỉ trong việc cấp phép phóng, mà còn trong tất cả các quy trình dẫn đến quyết định đó.

Việc quân sự hóa AI hơn nữa trong lĩnh vực hạt nhân sẽ dẫn thế giới vào con đường bất ổn và xung đột ngoài ý muốn, điều này khẳng định sự hoài nghi chung của các chuyên gia độc lập.